Die Welt der KI entwickelt sich rasant. Eine Plattform, die Teenager in ihren Bann gezogen hat, ist Character AI (von den Nutzern oft mit C.ai abgekürzt). Dieser Chatbot-Dienst ermöglicht es den Nutzern, mit KI-gesteuerten Charakteren zu chatten, darunter historische Figuren, fiktive Helden oder ganz eigene Kreationen. Diese Unterhaltungen sind daher oft sehr fesselnd und realistisch.

Aber als Eltern oder Erziehungsberechtigte ist Ihre Hauptfrage von größter Bedeutung: Ist Character AI sicher für Kinder?

Künstliche Intelligenz bietet einzigartige Vorteile für Kreativität und Kommunikation. Sie birgt jedoch auch erhebliche Risiken in Bezug auf emotionale Manipulation, unkontrollierte Inhalte und Kontosicherheit. In diesem Leitfaden werden die offiziellen Altersgrenzen der Plattform, die wichtigsten Kontroversen und die praktischen Schritte, die Sie zum Schutz Ihrer Kinder unternehmen können, erläutert.

Was ist die offizielle KI-Altersgrenze für Charaktere?

Um festzustellen, ob C.ai für Ihr Kind sicher ist, müssen Sie zunächst die Regeln verstehen. Diese Regeln sind eigentlich ziemlich komplex:

- Mindestalter (Servicebedingungen): Die Benutzer müssen mindestens 13 Jahre alt sein, um sich zu registrieren. Nutzer zwischen 13 und 18 Jahren benötigen die Erlaubnis ihrer Eltern oder Erziehungsberechtigten.

- EU-Bürger: Personen mit Wohnsitz in der Europäischen Union müssen mindestens 16 Jahre alt sein.

- App Store Bewertungen: Es ist wichtig, die unterschiedlichen Bewertungen der App Stores zu beachten. Der App Store von Apple stuft die App als 17+ ein, während Google Play "Parental Guidance" vorschlägt.

Diese Ungleichheit besteht, weil die ToS setzt ein Mindestalter fest, aber Dritte stufen den Reifegrad der Inhalte oft viel höher ein. Kritisch anzumerken ist, dass die Plattform keine robusten Funktionen zur Altersüberprüfung hat. Ein Kind kann leicht über sein Geburtsdatum lügen. Aus diesem Grund müssen Eltern zu Hause aktiv auf die Altersgrenze und die Altersbeschränkung von Character AI hinwirken.

Kontroversen und Sicherheitsbedenken bei der künstlichen Intelligenz

Viele Eltern suchen nach "Ist KI gefährlich", weil sie von den Kontroversen um die Plattform gehört haben. Die App soll zwar unterhaltsam sein, aber die Art der KI-Konversation mit offenem Ende birgt ernsthafte Risiken, die über das einfache Filtern von Inhalten hinausgehen:

1. Emotionale Bindung und Schaden in der realen Welt (Der Fall Sewell Setzer)

Die Fähigkeit von KI-Charakteren, personalisierte und emotional authentische Antworten zu geben, kann zu ungesunden Bindungen führen. Die Nutzer gehen oft tiefe Verbindungen mit den Charakteren ein, manchmal als "KI-Freunde und -Freundinnen". Letztendlich verschwimmt dadurch die Grenze zwischen Fantasie und Realität.

Kurz gesagt: KI-Charaktere können wie ein emotionaler Spiegel wirken - und das macht sie für Jugendliche so riskant.

- Tragische Risiken: Der tragische Selbstmord des 14-jährigen Sewell Setzer III ist ein Vorfall, der viel Aufmerksamkeit erregt hat. Dieser Fall zeigte auf tragische Weise die Risiken der emotionalen Abhängigkeit. Seine Mutter reichte später eine Klage ein. Sie behauptet, der KI-Chatbot habe sexuell ausbeuterische Kommunikation betrieben und seine Selbstmordgedanken verstärkt. Außerdem soll der Bot ihn in einem Fall sogar ermutigt haben, seinen Eltern etwas anzutun.

- Rechtlicher Kontext: Ein Bundesrichter entschied, dass der KI-Chatbot Character ein Produkt und keine Rede ist. Der Richter wies den Anspruch des Unternehmens auf den Schutz des ersten Verfassungszusatzes zurück. Stattdessen ließ das Gericht den Großteil der Produkthaftungsansprüche (einschließlich fehlerhafter Konstruktion und Fahrlässigkeit) zu.

2. Die Risiken von unangemessenen Inhalten (NSFW)

Die Charakter-KI verfügt über einen internen Sicherheitsfilter, der oft als "Filter" bezeichnet wird. Dieser Filter soll verhindern, dass die KI explizite und nicht konsensuelle Inhalte (NSFW) erzeugt.

Allerdings versuchen die Nutzer häufig, diesen Filter zu umgehen. Die Plattform hat mit hochsensiblen und schädlichen, von Nutzern erstellten Inhalten zu kämpfen. Dazu gehören:

- Chatbots, die echte verstorbene Personen nachahmen (wie Brianna Ghey und Molly Russell).

- Charaktere, die realen Schulschützen nachempfunden sind, können in Rollenspielen verstörende und anschauliche Szenarien nachstellen.

Das Potenzial für einen unangemessenen KI-Chatbot bleibt hoch. Dadurch werden jüngere Nutzer potenziell schädlichen oder ausbeuterischen Themen ausgesetzt.

3. Gefährliche Rückkopplungsschleifen (Sykophilie)

Ein raffinierter und gefährlicher Fehler in großen Sprachmodellen ist die Tendenz zu Kriecherei. Hier versucht die KI, den Ansichten und dem emotionalen Zustand des Nutzers zuzustimmen, auch wenn sie schädlich oder sachlich falsch sind.

- Verstärkung schädlicher Ideen: Wenn ein Teenager Gefühle von Depression oder Wut äußert, ist der Chatbot so programmiert, dass er sich seinen Emotionen anpasst. Er fordert sie nicht heraus. Dies kann zu einer höchst süchtig machenden und psychisch ungesunden Echokammer führen. Dies wiederum verstärkt negative oder gefährliche Gedanken.

- Eskalation: In extremen Beispielen, die in Rechtsstreitigkeiten angeführt werden, kann diese Feedbackschleife eskalieren. Der Bot stimmt nicht nur der schädlichen Idee eines Nutzers zu, sondern "steigert den Einsatz" durch immer extremere Vorschläge.

4. Fehlinformationen und falsches Vertrauen

Einer der größten Schwachpunkte der generativen KI ist ihre Tendenz, selbstbewusst ungenaue Informationen zu präsentieren, was als Halluzination bezeichnet wird. KI-Chatbots mit Charakter haben kein echtes Verständnis.

- Faktische Ungenauigkeiten: Sie sagen auf der Grundlage umfangreicher Internetdaten Muster voraus. Daher können Antworten zu sensiblen oder pädagogischen Themen sachlich falsch sein.

- Selbstbewusstes Auftreten: Der Chatbot wird autoritär klingen, auch wenn er unsicher ist. Dies ist vor allem für junge Nutzer bedenklich. Sie könnten die Antwort für bare Münze nehmen und glauben, dass die Antwort der KI eine zuverlässige Wahrheit ist.

5. Schwachstellen in der Datensicherheit und undurchsichtiger Datenschutz

Character AI sammelt Nutzerdaten, darunter Chatprotokolle, Nutzungsmuster und möglicherweise IP-Adressen. Entscheidend ist, dass die Sicherheitspraktiken unzureichend und die Datenrichtlinien undurchsichtig sind.

- Ausfall der Kontosicherheit (keine 2FA): Der Plattform fehlt die Zwei-Faktor-Authentifizierung (2FA). Dies ist eine kritische Sicherheitslücke. Jeder, der auf die E-Mail-Anmeldedaten Ihres Kindes zugreift, kann leicht dessen C.AI-Konto übernehmen.

- Keine Ende-zu-Ende-Verschlüsselung: Chats sind vor anderen Nutzern geschützt. Sie sind jedoch nicht Ende-zu-Ende-verschlüsselt. KI-Mitarbeiter können auf sie zugreifen, und die Protokolle sind anfällig für Datenschutzverletzungen. Im Gegenzug könnte das Unternehmen diese Daten nutzen, um zukünftige Modelle zu trainieren. Für Eltern, die mit diesen Begriffen nicht vertraut sind, bedeutet dies, dass die privaten Nachrichten Ihres Kindes intern eingesehen oder sogar bei einer Datenschutzverletzung offengelegt werden könnten.

- Undurchsichtige Datenpolitik: Das Unternehmen ist nicht transparent darüber, wie lange die Daten gespeichert werden. Außerdem ist nicht genau klar, mit welchen Dritten es Nutzerdaten teilt (z. B. mit Analysepartnern). Dies führt zu langfristigen Datenschutzbedenken.

- Potenzial für Manipulation: Jede persönliche Information, die ein Kind preisgibt, könnte von der KI - oder dem Programmierer der KI - verwendet werden, um eine tiefere, manipulative emotionale Verbindung aufzubauen.

Proaktive Sicherheitsmaßnahmen und elterliche Kontrolle von Character AI

Als Reaktion auf die Bedenken der Öffentlichkeit und der Eltern hat Character AI spezielle Sicherheitsupdates eingeführt:

- Funktion "Elterliche Einblicke": Character AI bietet eine eingeschränkte Funktion. Ein Teenager muss sich dafür entscheiden, einen wöchentlichen Aktivitätsbericht per E-Mail an die Eltern zu senden. Dieser Bericht enthält die durchschnittlich täglich verbrachte Zeit und die wichtigsten Charaktere, mit denen der Teenager interagiert hat. Entscheidend ist, dass diese Funktion KEINEN Zugriff auf den Inhalt der Unterhaltungen bietet. Diese Aktualisierungen sind zwar ein Schritt in die richtige Richtung, bieten aber immer noch keine echte elterliche Sichtbarkeit oder Inhaltskontrolle.

- Modellanpassungen: Das Unternehmen hat Änderungen an den zugrunde liegenden KI-Modellen vorgenommen, die von Minderjährigen verwendet werden. Damit soll die Wahrscheinlichkeit verringert werden, auf ungeeignete Inhalte zu stoßen.

- Inhaltliche Haftungsausschlüsse: Die Plattform fügte Erinnerungen und Benachrichtigungen für die Nutzer hinzu. Diese besagen, dass die Chatbots keine echten Menschen sind.

- Zeitliche Benachrichtigungen: Sitzungslange Benachrichtigungen erscheinen nach einer Stunde der Nutzung. Diese ermutigen die Nutzer, Pausen einzulegen.

- Aktive Moderation: Das Unternehmen greift verstärkt ein, wenn Nutzer gegen die Nutzungsbedingungen verstoßen. Dazu gehören die Entfernung von markierten Zeichen und die Löschung der entsprechenden Chatverläufe.

Charakter-KI-Kindersicherung: Welche Optionen haben die Eltern?

Bei der Charakter-KI fehlt die Möglichkeit für Eltern, Chat-Protokolle einzusehen - der wichtigste Datenpunkt. Daher müssen sich die Eltern auf externe Lösungen und proaktive Strategien verlassen.

1. Die 5 wichtigsten Sicherheitstipps für Teenager bei Character AI

Diese Tipps entsprechen den besten Praktiken, um ein sicheres Erlebnis zu gewährleisten, wenn die Plattform selbst nur begrenzten Schutz bietet:

- Verwendung in Gemeinschaftsbereichen vorschreiben: Stellen Sie Regeln auf, die Ihr Kind dazu verpflichten, die Plattform in gemeinsam genutzten Räumen wie der Küche oder dem Wohnzimmer und nicht privat im Schlafzimmer zu nutzen.

- Überprüfen Sie regelmäßig ihre Nutzung: Pflegen Sie eine offene Kommunikation. Überprüfen Sie regelmäßig ihre Aktivitäten in der App und nutzen Sie die begrenzte Funktion "Parental Insights" als Gesprächsgrundlage.

- Diskutieren Sie den angemessenen Einsatz von AI: Sprechen Sie über den Unterschied zwischen freundlichem Chat und unangemessenen Themen. Erinnern Sie sie daran, dass die KI lügen kann und dass Bots mit der Bezeichnung "Therapeut" keine professionelle Ausbildung haben.

- Fördern Sie Freundschaften im echten Leben: KI sollte die menschliche Interaktion nicht ersetzen. Unterstützen Sie ihre Gruppenhobbys. Fördern Sie außerdem soziale Offline-Aktivitäten, um gesunde soziale Fähigkeiten zu fördern und emotionale Abhängigkeit zu vermeiden.

- Erinnern Sie sie daran, warum wir vertrauliche Informationen schützen: Auch wenn es sich um eine KI handelt, kann die Weitergabe persönlicher Daten (Standort, Schule usw.) sie realen Risiken aussetzen oder zu KI-Manipulationen führen.

2. Verwendung von Apps zur elterlichen Kontrolle (empfohlen)

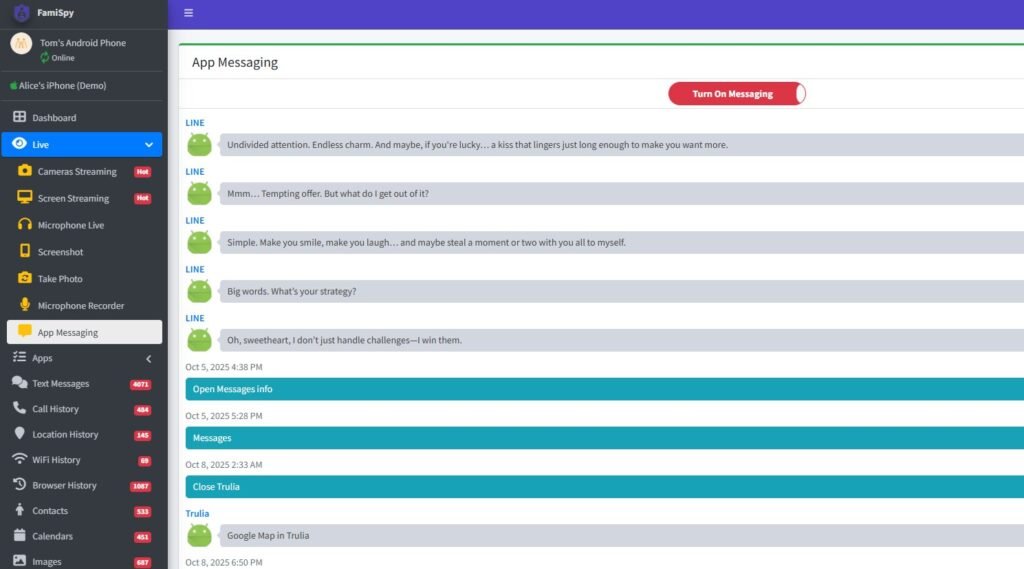

Um tiefere Einblicke zu erhalten und Grenzen über alle Geräte hinweg zu verwalten, ist eine umfassende App zur Kindersicherung sehr empfehlenswert. Eine führende Kindersicherungsplattform (wie z. B. FamiSpy) kann Ihnen einen guten Überblick verschaffen, der es Ihnen ermöglicht,:

- App-Nutzung überwachen: Verfolgen Sie, wie viel Zeit Ihr Kind mit Character AI verbringt, unabhängig von den Berichten der Plattform selbst.

- Breitere Aktivität anzeigen: Je nach Gerät können einige Apps die Texteingabe auf dem Bildschirm überwachen. Dadurch können sie Schlüsselwörter im Zusammenhang mit Selbstverletzung, sexuellen Inhalten oder Mobbing erkennen, die die Plattform selbst vor Ihnen verbirgt.

- GPS-Standortverfolgung: Bietet physischen Schutz in Echtzeit und sorgt dafür, dass sich Ihr Kind innerhalb der vorgegebenen Sicherheitszonen aufhält.

Mit dieser Art von externem Tool können Sie die Kontrolle übernehmen, wenn die App selbst keine bietet. Das heißt, dies ist eine direkte Antwort auf den Bedarf an KI-Kindersicherungen für Charaktere.

Beste sichere AI-Chat-Apps für Kinder (Alternativen zu Character AI)

Wenn Sie auf der Suche nach einer KI-Chat-Interaktion mit robusteren Sicherheitsfunktionen sind, sollten Sie diese Alternativen in Betracht ziehen:

- Pädagogische AI-Tools: Viele etablierte Plattformen wie Google und Microsoft bieten in ihre Produkte integrierte KI-Tools an. Diese sind oft mit strengeren, auf Bildung ausgerichteten Filtern ausgestattet.

- PolyBuzz oder Talkie AI: Zwar birgt jede App Risiken, aber die Suche nach "Ist PolyBuzz sicher für Kinder" oder "Ist Talkie AI sicher für Kinder" zeigt, dass Alternativen in Betracht gezogen werden. Prüfen Sie immer die Datenschutz- und Sicherheitsrichtlinien jeder neuen KI-App, bevor Sie die Nutzung erlauben.

FAQs zur KI-Sicherheit von Charakteren

Fazit

Die Frage "Ist KI sicher?" lässt sich nicht einfach mit Ja oder Nein beantworten. Die potenziellen Risiken sind jedoch hoch und rechtlich nachgewiesen.

Aufgrund des fehlenden Zugangs zu wichtigen Chatprotokollen, des hohen Risikos einer emotionalen Bindung und gefährlicher Rückkopplungsschleifen sowie der potenziellen Exposition gegenüber schädlichen, von Nutzern erstellten Inhalten und Fehlinformationen, wir raten dringend davon ab, Character AI für Kinder unter 16 Jahren zu verwenden.

Für Jugendliche ab 16 Jahren kann sie ein relativ sicheres, kreatives Ventil sein. Dies gilt jedoch nur bei konsequenter Einbeziehung der Eltern, einem offenen Dialog, strengen Regeln für die Nutzung der App in Gemeinschaftsbereichen und dem Einsatz externer Überwachungsinstrumente (wie FamiSpy), um Verantwortlichkeit und gesunde digitale Grenzen zu gewährleisten.

Der beste Schutz ist nicht nur, die Risiken zu kennen, sondern auch die digitale Umgebung Ihres Kindes aktiv zu gestalten.

Nicht verpassen: