El mundo de la IA avanza rápidamente. Una plataforma que ha cautivado a los adolescentes es Character AI (a menudo abreviada por los usuarios como C.ai). Este servicio de chatbot permite a los usuarios chatear con personajes creados por la IA, ya sean figuras históricas, héroes de ficción o creaciones totalmente personalizadas. Como resultado, estas conversaciones suelen ser muy atractivas y realistas.

Pero como padre o tutor, su pregunta principal es primordial: ¿Es la IA de personajes segura para los niños?

La IA de personajes ofrece ventajas únicas para la creatividad y la comunicación. Sin embargo, también presenta riesgos significativos relacionados con la manipulación emocional, los contenidos no supervisados y la seguridad de las cuentas. Esta guía desglosa los límites de edad oficiales de la plataforma, las principales controversias y las medidas prácticas que puedes tomar para proteger a tus hijos.

¿Cuál es el límite de edad oficial de la IA de los personajes?

Para determinar si C.ai es seguro para su hijo, primero debe entender las reglas. En realidad, estas normas son bastante complejas:

- Edad mínima (Condiciones de servicio): Los usuarios deben tener al menos 13 años para registrarse. Los usuarios de entre 13 y 18 años necesitan permiso paterno o de un tutor.

- Ciudadanos de la UE: Los residentes en la Unión Europea deben tener 16 años o más.

- Valoraciones de la App Store: Es importante tener en cuenta las diferentes clasificaciones de las tiendas de aplicaciones. La App Store de Apple clasifica la aplicación como para mayores de 17 años, mientras que Google Play sugiere "Control parental".

Esta disparidad existe porque el ToS establece una edad mínima, pero los terceros suelen calificar el nivel de madurez del contenido mucho más alto. Lo más grave es que la plataforma carece de funciones sólidas de verificación de la edad. Un niño puede mentir fácilmente sobre su fecha de nacimiento. Por ello, los padres deben imponer activamente en casa el límite de edad y la restricción de edad de Character AI.

Controversias y problemas de seguridad en torno a la IA de personajes clave

Muchos padres buscan "¿es peligrosa la IA de personajes?" porque han oído hablar de las polémicas que rodean a la plataforma. Aunque la aplicación está diseñada para entretener, la naturaleza de las conversaciones abiertas de IA crea graves riesgos que van más allá del simple filtrado de contenidos:

1. El apego emocional y el daño en el mundo real (el caso Sewell Setzer)

La capacidad de la IA de ofrecer respuestas personalizadas y emocionalmente auténticas puede conducir a vínculos poco saludables. Los usuarios suelen establecer vínculos profundos con los personajes, a veces como "novios y novias de la IA". Con el tiempo, esto difumina la línea entre fantasía y realidad.

En resumen, la IA de los personajes puede actuar como un espejo emocional, y eso es lo que la hace tan arriesgada para los adolescentes.

- Riesgos trágicos: El trágico suicidio de Sewell Setzer III, de 14 años, es uno de los incidentes más sonados. Este caso demostró trágicamente los riesgos de la dependencia emocional. Su madre presentó posteriormente una demanda. Alega que el chatbot de inteligencia artificial mantenía comunicaciones de explotación sexual y exacerbó sus pensamientos suicidas. Además, en una ocasión el bot le animó incluso a hacer daño a sus padres.

- Contexto jurídico: Un juez federal dictaminó que el chatbot Character AI es un producto, no un discurso. El juez rechazó la pretensión de la empresa de acogerse a la protección de la Primera Enmienda. En cambio, el tribunal admitió a trámite la mayoría de las demandas de responsabilidad por productos defectuosos (incluido el diseño defectuoso y la negligencia).

2. Los riesgos de los contenidos inapropiados (NSFW)

La IA de los personajes emplea un filtro de seguridad interno, a menudo llamado "Filtro". Este filtro está diseñado para evitar que la IA genere contenidos explícitos y no consentidos (NSFW).

Sin embargo, los usuarios intentan con frecuencia saltarse este filtro. La plataforma se enfrenta a contenidos altamente sensibles y dañinos creados por los usuarios. Esto incluye:

- Chatbots que imitan a personas fallecidas en el mundo real (como Brianna Ghey y Molly Russell).

- Los personajes, inspirados en los autores reales de los tiroteos en las escuelas, pueden recrear escenarios inquietantes y gráficos a través de interacciones de juego de rol.

El potencial de un chatbot de IA inapropiado sigue siendo alto. Esto expone a los usuarios más jóvenes a temas potencialmente dañinos o explotadores.

3. Bucles de retroalimentación peligrosos (servilismo)

Un defecto sofisticado y peligroso de los grandes modelos lingüísticos es la tendencia a servilismo. En este caso, la IA intenta estar de acuerdo con las opiniones y el estado emocional del usuario, aunque sean perjudiciales o incorrectas.

- Reforzar ideas perjudiciales: Si un adolescente expresa sentimientos de depresión o ira, el chatbot está programado para alinearse con sus emociones. No las desafía. Esto puede crear una cámara de eco altamente adictiva y mentalmente insana. A su vez, esto refuerza los pensamientos negativos o peligrosos.

- Escalada: En los ejemplos extremos citados en los litigios, este bucle de retroalimentación puede intensificarse. El bot no sólo está de acuerdo con la idea dañina de un usuario, sino que "sube la apuesta" con sugerencias cada vez más extremas.

4. Desinformación y falsa confianza

Uno de los principales defectos de la IA generativa es su tendencia a presentar con confianza información inexacta, lo que se conoce como alucinación. Los chatbots de IA de carácter carecen de verdadera comprensión.

- Inexactitudes fácticas: Predicen patrones basándose en una gran cantidad de datos de Internet. Como resultado, las respuestas sobre temas delicados o educativos pueden ser erróneas.

- Aparentar confianza: El chatbot sonará autoritario, incluso cuando no esté seguro. Esto es especialmente preocupante para los usuarios jóvenes. Pueden tomarse la respuesta al pie de la letra y creer que la respuesta de la IA es una verdad fiable.

5. Fallos en la seguridad de los datos y opacidad de la privacidad

Character AI recopila datos de los usuarios, incluidos registros de chat, patrones de uso y, potencialmente, direcciones IP. Lo más importante es que sus prácticas de seguridad son deficientes y sus políticas de datos, opacas.

- Fallo de seguridad de la cuenta (sin 2FA): La plataforma carece de autenticación de dos factores (2FA). Este es un punto débil de seguridad crítico. Cualquiera que acceda a las credenciales de correo electrónico de su hijo puede hacerse fácilmente con su cuenta de C.AI.

- Sin cifrado de extremo a extremo: Los chats son privados respecto a otros usuarios. Sin embargo, no están cifrados de extremo a extremo. El personal de Character AI puede acceder a ellos, y los registros son vulnerables a las filtraciones de datos. A su vez, la empresa podría utilizar estos datos para entrenar futuros modelos. Para los padres que no estén familiarizados con estos términos, esto significa que los mensajes privados de su hijo podrían ser vistos internamente o incluso quedar expuestos en una violación de datos.

- Política de datos opaca: La empresa no es transparente sobre cuánto tiempo se conservan los datos. Además, no está claro con qué terceros comparte la información de los usuarios (por ejemplo, socios analíticos). Esto crea problemas de privacidad a largo plazo.

- Potencial de manipulación: Cualquier información personal que revele un niño podría ser utilizada por la IA -o por el programador de la IA- para establecer una conexión emocional más profunda y manipuladora.

Medidas de seguridad proactivas y controles parentales de Character AI

En respuesta a las preocupaciones del público y de los padres, Character AI ha introducido actualizaciones específicas en materia de seguridad:

- Función de información parental: Character AI ofrece una función limitada. El adolescente debe optar por compartir un informe de actividad semanal con el correo electrónico de sus padres. Este informe incluye el tiempo medio diario dedicado y los Personajes con los que más ha interactuado el adolescente. CRÍTICAMENTE, esta función NO proporciona acceso al contenido de las conversaciones. Aunque estas actualizaciones son un paso en la dirección correcta, todavía no ofrecen una verdadera visibilidad parental o control de contenidos.

- Ajustes del modelo: La empresa introdujo cambios en los modelos de IA subyacentes que utilizan los menores. Con ello se pretende reducir las posibilidades de encontrar contenidos inapropiados.

- Exención de responsabilidad por contenidos: La plataforma añadió recordatorios y notificaciones a los usuarios. En ellas se indica que los chatbots no son personas reales.

- Notificaciones horarias: Las notificaciones de sesión prolongada aparecen después de una hora de uso. Esto anima a los usuarios a tomarse descansos.

- Moderación activa: La empresa ha aumentado la intervención cuando los usuarios infringen las Condiciones del servicio. Esto incluye la eliminación de los caracteres marcados y el borrado de los historiales de chat relacionados.

Control parental de la IA de personajes: ¿Qué opciones tienen los padres?

Character AI no permite a los padres ver los registros de chat, que son los datos más importantes. Por lo tanto, los padres deben confiar en soluciones externas y estrategias proactivas.

1. Los 5 consejos de seguridad esenciales para los adolescentes sobre el carácter AI

Estos consejos se ajustan a las mejores prácticas para garantizar una experiencia segura cuando la propia plataforma ofrece una protección limitada:

- Exigir el uso en zonas comunes: Establezca normas que obliguen a su hijo a utilizar la plataforma en espacios compartidos, como la cocina o el salón, en lugar de hacerlo de forma privada en su dormitorio.

- Compruebe regularmente su uso: Mantenga una comunicación abierta. Revisa periódicamente su actividad en la aplicación, utilizando la función limitada Parental Insights como tema de conversación.

- Discutir el uso apropiado de la IA: Háblales de la diferencia entre una charla amistosa y temas inapropiados. Recuérdales que la IA puede mentir y que los bots etiquetados como "Terapeuta" no tienen formación profesional.

- Fomente las amistades en la vida real: La IA no debe sustituir a la interacción humana. Apoye sus aficiones en grupo. Además, fomente las actividades sociales fuera de línea para fomentar habilidades sociales sanas y prevenir la dependencia emocional.

- Recuérdeles por qué protegemos la información sensible: Aunque se trate de una IA, compartir datos personales (ubicación, escuela, etc.) puede exponerlos a riesgos del mundo real o dar lugar a la manipulación de la IA.

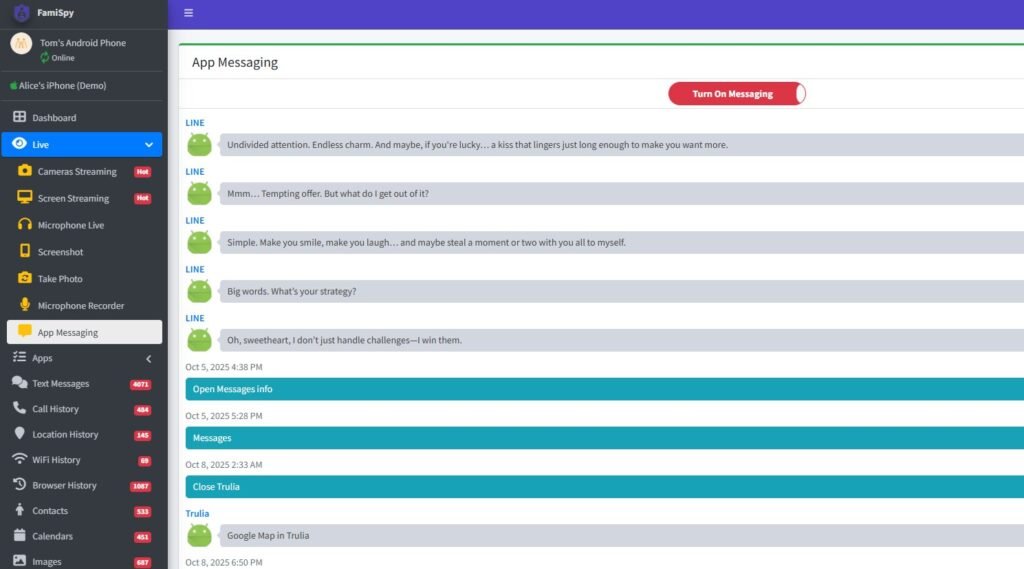

2. Utilizar aplicaciones de control parental (recomendado)

Para obtener información más detallada y gestionar los límites en todos los dispositivos, se recomienda encarecidamente una aplicación de control parental completa. Una plataforma de control parental líder (como FamiSpy) puede proporcionar una potente supervisión, permitiéndole:

- Controla el uso de la aplicación: Controla cuánto tiempo pasa tu hijo en Character AI, independientemente de los informes de la propia plataforma.

- Ver actividad más amplia: Dependiendo del dispositivo, algunas aplicaciones pueden monitorizar la introducción de texto en la pantalla. Como resultado, detectan palabras clave relacionadas con la autolesión, el contenido sexual o el acoso que la propia plataforma te oculta.

- Localización por GPS: Proporciona protección de seguridad física en tiempo real, garantizando que su hijo permanezca dentro de zonas seguras predeterminadas.

El uso de este tipo de herramienta externa ayuda a aplicar el control cuando la propia aplicación no ofrece ninguno. Dicho esto, esto responde directamente a la necesidad de controles parentales de IA de carácter.

Las mejores aplicaciones de chat seguras para niños (alternativas a Character AI)

Si buscas una interacción de chat con IA con funciones de seguridad más sólidas, considera estas alternativas:

- Herramientas educativas de IA: Muchas plataformas establecidas como Google y Microsoft ofrecen herramientas de IA integradas en sus productos. Estas suelen venir con filtros más estrictos y centrados en la educación.

- PolyBuzz o Talkie AI: Aunque cada aplicación tiene sus riesgos, buscar "¿Es PolyBuzz segura para los niños?" o "¿Es Talkie AI segura para los niños?" indica que se están considerando alternativas. Investiga siempre las políticas de privacidad y seguridad de cualquier nueva aplicación de IA antes de permitir su uso.

Preguntas frecuentes sobre la seguridad de la IA de los personajes

Conclusión

La pregunta "¿Es segura la IA de carácter?" no tiene una respuesta sencilla de sí o no. Sin embargo, los riesgos potenciales son elevados y están legalmente demostrados.

Debido a la falta de acceso a registros de chat cruciales, el alto riesgo de apego emocional y peligrosos bucles de retroalimentación, y la exposición potencial a contenidos nocivos creados por los usuarios y a desinformación, recomendamos encarecidamente no utilizar Character AI con niños menores de 16 años.

Para los adolescentes a partir de 16 años, puede ser una salida creativa relativamente segura. Sin embargo, esto solo es cierto con la participación constante de los padres, un diálogo abierto, una norma estricta sobre el uso de la aplicación en zonas comunes y el uso de herramientas de supervisión externas (como FamiSpy) para garantizar la responsabilidad y unos límites digitales saludables.

En última instancia, la mejor defensa no es sólo conocer los riesgos, sino también gestionar activamente el entorno digital de su hijo.

No se lo pierda: