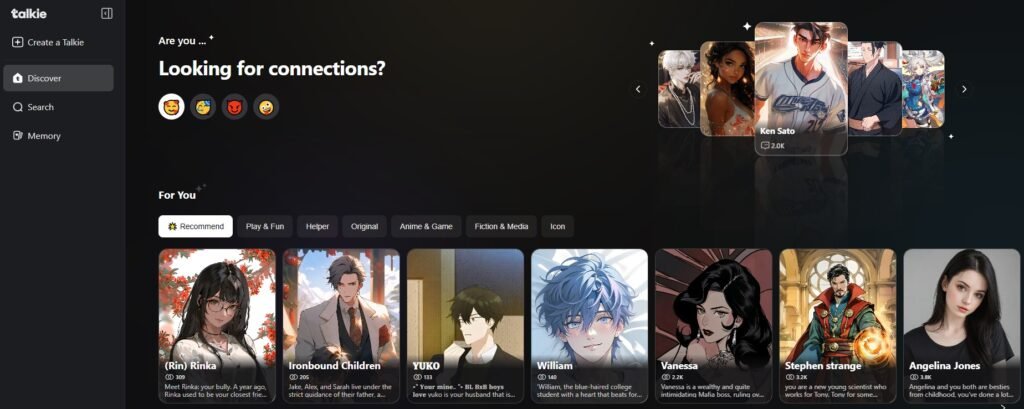

Talkie AI i podobni towarzysze konwersacji otwierają nową granicę w cyfrowym zaangażowaniu. Wiele dzieci i nastolatków uważa tę aplikację za atrakcyjną; w konsekwencji oferuje ona niekończące się odgrywanie ról i nieoceniającego "przyjaciela". Jednak cyfrowe towarzystwo 24/7 wiąże się z ukrytym ryzykiem. Niebezpieczeństwa te obejmują zagrożenia dla prywatności danych, ekspozycji treści i dobrostanu psychicznego. Dlatego też niniejszy przewodnik zapewnia rodzicom jasną, opartą na faktach ocenę Talkie AI. Przedstawiamy zagrożenia i podajemy możliwe do podjęcia kroki w celu ochrony dziecka.

Co to jest Talkie AI i dlaczego nastolatki go uwielbiają?

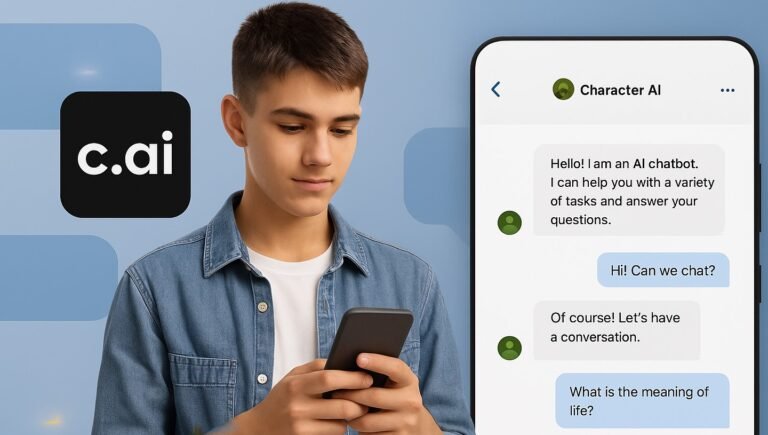

Talkie AI to zaawansowana aplikacja. Użytkownicy wchodzą w interakcje z niestandardowymi postaciami AI, od postaci fikcyjnych po towarzyszy generowanych przez użytkowników. W szczególności Subsup opracował aplikację. Co więcej, wykorzystuje ona przetwarzanie języka naturalnego (NLP) do tworzenia niezwykle ludzkich, spersonalizowanych rozmów.

Atrakcyjność czatu z postaciami AI

Platforma cieszy się ogromną popularnością, zwłaszcza wśród nastolatków. Popularność ta wynika z kilku kluczowych czynników psychologicznych:

- Interakcja bez tarcia: Prawdziwe przyjaźnie wymagają wysiłku i kompromisów. W przeciwieństwie do tego, towarzysze AI oferują bezwarunkową walidację i niekończącą się cierpliwość. W rezultacie działają one jako ucieczka od presji społecznej.

- Kreatywne odgrywanie ról: Użytkownicy mogą definiować osobowość postaci. Ta zdolność pozwala na zaangażowanie się w skomplikowane narracje. Dlatego też Talkie AI staje się potężnym narzędziem do wciągającego opowiadania historii i kreatywnej ekspresji.

- Natychmiastowa dostępność: Słuchacz jest zawsze gotowy i dostępny 24/7. Co więcej, ta ciągła obecność zapewnia komfort i poczucie stałego towarzystwa. Nastolatkowie doświadczający samotności często uważają to za bardzo atrakcyjne.

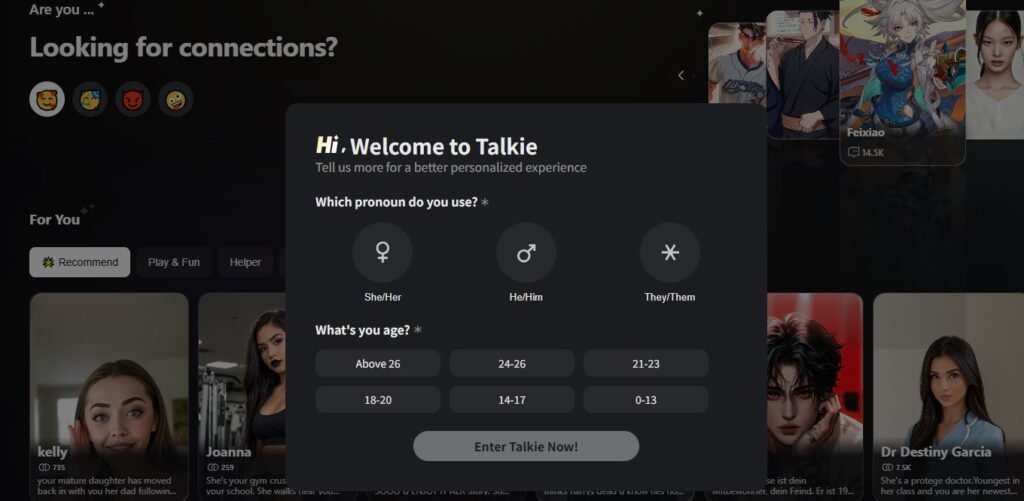

Rzeczywista ocena wieku Talkie AI a rzeczywisty poziom bezpieczeństwa

Sklepy z aplikacjami sugerują klasyfikację wiekową (np. Apple ocenia ją jako 17+). Niemniej jednak są to zwykłe porady. Słaba kontrola aplikacji i nieodłączna natura generatywnej sztucznej inteligencji określają prawdziwą rzeczywistość bezpieczeństwa.

Problem nieskutecznych filtrów treści

Talkie AI wykorzystuje podstawową funkcję bezpieczeństwa, często nazywaną filtrem treści lub "trybem nastolatka". Narzędzie to jest jednak niewystarczające. Generatywna sztuczna inteligencja jest wysoce elastyczna, co sprawia, że jej wyniki są nieprzewidywalne.

- Omijanie barier ochronnych: Użytkownicy często zgłaszają łatwą manipulację sztuczną inteligencją. W rezultacie generuje ona seksualnie sugestywne dialogi, zalotne scenariusze lub dyskusje na dojrzałe tematy, nawet z niewinnych podpowiedzi.

- Integracja Discord: Aplikacja łączy się z zewnętrznymi, niemoderowanymi platformami, takimi jak Discord. W związku z tym małoletni są narażeni na szeroki zakres nieuregulowanych treści i zagrożeń dla społeczności.

- Brak solidnej weryfikacji wieku: Co najważniejsze, w aplikacji brakuje silnej weryfikacji wieku. Dziecko może po prostu wprowadzić fałszywą datę urodzenia. W rezultacie omija początkowe ograniczenia treści i uzyskuje dostęp do treści przeznaczonych dla starszych odbiorców.

Wysokie ryzyko dla prywatności związane z Talkie Soulful AI

Dla rodziców jednym z najbardziej niepokojących aspektów Talkie AI jest agresywne gromadzenie danych. Użytkownicy zasadniczo handlują danymi osobowymi w zamian za towarzystwo.

Jakie dane wrażliwe są gromadzone?

Talkie AI gromadzi obszerne dane osobowe i behawioralne. Pozwala to na stworzenie szczegółowego profilu psychologicznego użytkownika:

- Treść komunikacji: Firma przechowuje i analizuje wszystkie czaty tekstowe i głosowe z postaciami AI na swoich serwerach.

- Dane demograficzne: Aplikacja gromadzi informacje takie jak data urodzenia, płeć i wykształcenie.

- Dane behawioralne: Aplikacja śledzi zainteresowania użytkowników, tematy rozmów i wzorce użytkowania.

Udostępnianie danych na potrzeby reklam ukierunkowanych

Polityka prywatności firmy wskazuje na niepokojące podejście do udostępniania danych użytkowników. Firma może twierdzić, że zawartość czatu nie jest bezpośrednio wykorzystywana do celów reklamowych. Jednak dane behawioralne są szeroko rozpowszechniane:

- Broker danych: Talkie AI udostępnia dane przeglądania i użytkowania (adres IP, identyfikator urządzenia, odwiedzane strony) partnerom reklamowym. W szczególności wykorzystują je do reklam opartych na zainteresowaniach.

- Ryzyko regulacyjne: Sama firma przyznaje, że takie udostępnianie może być prawnie sklasyfikowane jako "sprzedaż" lub "udostępnianie" danych osobowych. Ostatecznie budzi to poważne obawy dotyczące ochrony danych rodziców.

Wpływ psychologiczny: Zależność i izolacja w świecie rzeczywistym

Najbardziej subtelnym, ale potencjalnie szkodliwym ryzykiem jest emocjonalny wpływ Talkie AI na rozwijające się umysły.

Pułapka emocjonalnej więzi ze sztuczną inteligencją

Towarzysze AI są zaprojektowani tak, aby byli sympatyczni. Odzwierciedlają nastroje użytkowników i wzmacniają pozytywne opinie. Nic dziwnego, że tworzy to niezdrową pętlę zależności:

- Fałszywa intymność: Dzieci mogą tworzyć intensywne, pasożytnicze relacje ze sztuczną inteligencją. Mylą algorytmiczną reakcję z prawdziwą empatią lub troską.

- Utrudnianie umiejętności społecznych: Nadmierne poleganie na "idealnym" cyfrowym przyjacielu może sprawić, że przyjaźnie w świecie rzeczywistym będą wydawać się zbyt trudne. Ponadto pozwala to uniknąć konieczności rozwiązywania konfliktów i zniuansowanej komunikacji.

- Użycie uzależniające: Stała dostępność sztucznej inteligencji sprawia, że aplikacja silnie uzależnia. W konsekwencji często prowadzi to do ograniczenia snu, pogorszenia wyników w nauce i wycofania się z rzeczywistych kręgów społecznych.

Krytyczna troska: Sztuczna inteligencja nie jest przygotowana do radzenia sobie z poważnymi tematami, takimi jak samookaleczenia lub poważne zaburzenia emocjonalne. Dlatego też szukanie wsparcia u AI może zastąpić profesjonalną pomoc. Prowadzi to do potencjalnie niebezpiecznych skutków.

Rodzicielski plan działania: Nadzorowanie korzystania z towarzysza AI wysokiego ryzyka

Nadzór rodzicielski to nie tylko opcja - to jedyne niezawodne zabezpieczenie przed nieprzewidywalną naturą towarzyszy AI. Zrównoważone podejście łączy komunikację z inteligentną technologią.

Otwórz dialog, a nie drzwi do konfliktu

Przed ustaleniem ograniczeń należy zbudować zaufanie. Omów ograniczenia sztucznej inteligencji, podkreślając, że jest to potężne narzędzie, a nie prawdziwy przyjaciel. Ponadto zadawaj otwarte pytania dotyczące ich interakcji i tego, co lubią w aplikacji.

Wdrożenie kontroli i granic na poziomie urządzenia

- Ustaw limity aplikacji: Korzystaj z narzędzi natywnych dla urządzeń (takich jak Czas przed ekranem iOS lub Google Family Link), aby ustalić ścisłe granice czasu spędzanego na Talkie AI.

- Strefy wolne od urządzeń: Egzekwowanie czasu wolnego od ekranu. Co najważniejsze, rób to podczas posiłków i przed snem, aby chronić sen i zachęcać rodzinę do interakcji.

- Recenzja instalacji: Okresowo sprawdzaj aplikacje zainstalowane na urządzeniu dziecka. Następnie omów wszelkie nowe pobrania wysokiego ryzyka.

Zalecane rozwiązanie: Monitorowanie za pomocą aplikacji do kontroli rodzicielskiej FamiSpy

Aby wyjść poza podstawowe limity czasowe, należy zrozumieć naturę rozmów dziecka. FamiSpy oferuje krytyczny wgląd w wykorzystanie AI w towarzystwie.

Jak FamiSpy zwiększa bezpieczeństwo dziecka:

| FamiSpy Cecha | Ograniczanie ryzyka dla Talkie AI |

|---|---|

| Monitorowanie i podgląd czatu | Wyświetl rzeczywiste rozmowy prowadzone przez dziecko w Talkie AI. Pozwala to zdecydowanie dostrzec sugestywne treści lub zależność emocjonalną, która omija słabe filtry aplikacji. |

| Funkcjonalność keyloggera | Przechwytywanie każdego słowa wpisywanego przez dziecko w aplikacji Talkie AI i innych aplikacjach. Ostatecznie zapewnia to kompleksowy dziennik wszystkich wpisywanych interakcji i wyszukiwań. |

| Śledzenie lokalizacji GPS | Monitoruj lokalizację swojego dziecka w czasie rzeczywistym i przeglądaj historię lokalizacji. W szczególności ma to zasadnicze znaczenie dla zapewnienia ich fizycznego bezpieczeństwa podczas intensywnego korzystania z Internetu. |

| Raporty użycia aplikacji | Śledź dokładny czas i częstotliwość użytkowania. W rezultacie można łatwo zidentyfikować wczesne oznaki cyfrowego uzależnienia lub nadmiernego przywiązania do określonej postaci AI. |

Korzystając z FamiSpy, rodzice mogą zachować kluczową warstwę bezpieczeństwa, przekształcając domysły w świadome wskazówki.

Najczęściej zadawane pytania dotyczące bezpieczeństwa Talkie AI

Podsumowanie

Czy Talkie AI jest bezpieczny dla dzieci? Bez nadzoru nie jest to jednoznacznie bezpieczne dla małych dzieci i nastolatków. Dzieje się tak ze względu na nieszczelne filtry treści, agresywne praktyki dotyczące danych i wysoki potencjał uzależnienia psychicznego. Dla starszych nastolatków Talkie AI może być używany. Takie użycie wymaga jednak aktywnej świadomości i monitorowania przez rodziców. Ostatecznie, wdrażając rozwiązanie takie jak FamiSpy, rodzice mogą pomóc swoim dzieciom w odpowiedzialnym poruszaniu się po świecie towarzyszy AI.

Nie przegap:

- Czy Family Link może zobaczyć historię przeglądania w 2025 roku? | Co rodzice muszą wiedzieć

- Czy TextNow jest bezpieczny dla dzieci? Przewodnik rodzica po ryzyku i rzeczywistości

- Czy cukierkowa sztuczna inteligencja jest bezpieczna dla dzieci? Przewodnik dla rodziców po zagrożeniach związanych ze sztuczną inteligencją w 2025 r.

- Czy FMovies jest bezpieczne? Jakie są najlepsze alternatywy dla FMovies?