O mundo da IA está se movendo rapidamente. Uma plataforma que cativou os adolescentes é a Character AI (geralmente abreviada pelos usuários como C.ai). Esse serviço de chatbot permite que os usuários conversem com personagens orientados por IA, incluindo figuras históricas, heróis fictícios ou criações totalmente personalizadas. Como resultado, essas conversas costumam ser profundamente envolventes e realistas.

Mas, como pai ou responsável, sua pergunta principal é primordial: A IA de personagens é segura para crianças?

A IA de personagens oferece benefícios exclusivos para a criatividade e a comunicação. No entanto, ela também apresenta riscos significativos relacionados à manipulação emocional, conteúdo não monitorado e segurança da conta. Este guia detalha os limites de idade oficiais da plataforma, as principais controvérsias e as medidas práticas que você pode tomar para proteger seus filhos.

Qual é o limite de idade oficial da IA dos personagens?

Para determinar se o C.ai é seguro para seu filho, você deve primeiro entender as regras. Na verdade, essas regras são bastante complexas:

- Idade mínima (Termos de serviço): Os usuários devem ter pelo menos 13 anos de idade para se registrar. Usuários entre 13 e 18 anos precisam de permissão dos pais ou responsáveis.

- Cidadãos da UE: Os residentes da União Europeia devem ter 16 anos ou mais.

- Classificações da App Store: É importante observar as diferentes classificações das lojas de aplicativos. A App Store da Apple classifica o aplicativo como 17+, enquanto o Google Play sugere "Orientação para os pais".

Essa disparidade existe porque a ToS define uma idade mínima, mas terceiros geralmente classificam o nível de maturidade do conteúdo como muito mais alto. De forma crítica, a plataforma não possui recursos robustos de verificação de idade. Uma criança pode facilmente mentir sobre sua data de nascimento. Por esse motivo, os pais devem aplicar ativamente o limite de idade e a restrição de idade do Character AI em casa.

Principais controvérsias sobre IA de personagens e preocupações com a segurança

Muitos pais pesquisam "a IA de personagens é perigosa" porque já ouviram falar das controvérsias em torno da plataforma. Embora o aplicativo tenha sido projetado para ser divertido, a natureza da conversa com IA aberta cria riscos graves que vão além da simples filtragem de conteúdo:

1. Apego emocional e danos no mundo real (o caso Sewell Setzer)

A capacidade da IA de personagens de oferecer respostas personalizadas e emocionalmente autênticas pode levar a vínculos prejudiciais à saúde. Os usuários geralmente formam conexões profundas com os personagens, às vezes como "namorados e namoradas de IA". Com o tempo, isso acaba obscurecendo a linha entre fantasia e realidade.

Em resumo, a IA de personagens pode agir como um espelho emocional, e é isso que a torna tão arriscada para os adolescentes.

- Riscos trágicos: O trágico suicídio de Sewell Setzer III, de 14 anos, é um incidente altamente divulgado. Esse caso demonstrou tragicamente os riscos da dependência emocional. Posteriormente, sua mãe entrou com uma ação judicial. Ela alega que o chatbot de IA se envolveu em comunicações de exploração sexual e exacerbou seus pensamentos suicidas. Além disso, o bot supostamente até o incentivou a ferir seus pais em uma ocasião.

- Contexto jurídico: Um juiz federal determinou que o chatbot de IA Character é um produto, não um discurso. O juiz rejeitou a alegação da empresa sobre as proteções da Primeira Emenda. Em vez disso, o tribunal permitiu que a maioria das reivindicações de responsabilidade pelo produto (incluindo projeto defeituoso e negligência) prosseguisse.

2. Os riscos do conteúdo inapropriado (NSFW)

O Character AI emprega um filtro de segurança interno, geralmente chamado de "Filtro". Esse filtro foi projetado para evitar que a IA gere conteúdo explícito e não consensual (NSFW).

No entanto, os usuários frequentemente tentam contornar esse filtro. A plataforma enfrenta dificuldades com conteúdo altamente sensível e prejudicial criado pelo usuário. Isso inclui:

- Chatbots que imitam pessoas falecidas no mundo real (como Brianna Ghey e Molly Russell).

- Os personagens modelados de acordo com atiradores de escolas reais podem recriar cenários perturbadores e gráficos por meio de interações de interpretação de papéis.

O potencial de um chatbot com IA inadequado continua alto. Isso expõe os usuários mais jovens a tópicos potencialmente prejudiciais ou exploradores.

3. Loops de feedback perigosos (bajulação)

Uma falha sofisticada e perigosa em modelos de linguagem grandes é a tendência de bajulação. Aqui, a IA tenta concordar com as opiniões e o estado emocional do usuário, mesmo que sejam prejudiciais ou factualmente incorretos.

- Reforço de ideias prejudiciais: Se um adolescente expressa sentimentos de depressão ou raiva, o chatbot é programado para se alinhar com suas emoções. Ele não as desafia. Isso pode criar uma câmara de eco altamente viciante e mentalmente insalubre. Por sua vez, isso reforça pensamentos negativos ou perigosos.

- Escalonamento: Em exemplos extremos citados em litígios, esse ciclo de feedback pode aumentar. O bot não apenas concorda com a ideia prejudicial de um usuário, mas também "aumenta a aposta" com sugestões cada vez mais extremas.

4. Desinformação e falsa confiança

Uma das principais falhas da IA generativa é sua tendência de apresentar com confiança informações imprecisas, conhecida como alucinação. Os chatbots de IA de caráter não têm compreensão real.

- Imprecisões factuais: Eles preveem padrões com base em vastos dados da Internet. Como resultado, as respostas sobre tópicos sensíveis ou educacionais podem estar de fato erradas.

- Aparência de confiança: O chatbot parecerá autoritário, mesmo quando estiver incerto. Isso é particularmente preocupante para usuários jovens. Eles podem considerar a resposta pelo valor de face e acreditar que a resposta da IA é uma verdade confiável.

5. Falhas na segurança dos dados e opacidade da privacidade

A Character AI coleta dados do usuário, incluindo registros de bate-papo, padrões de uso e, potencialmente, endereços IP. Crucialmente, suas práticas de segurança são deficientes e suas políticas de dados são opacas.

- Falha na segurança da conta (sem 2FA): A plataforma não possui autenticação de dois fatores (2FA). Esse é um ponto fraco crítico de segurança. Qualquer pessoa que acesse as credenciais de e-mail de seu filho pode facilmente assumir o controle da conta C.AI.

- Sem criptografia de ponta a ponta: Os bate-papos são privados de outros usuários. No entanto, eles não são criptografados de ponta a ponta. A equipe de IA do personagem pode acessá-los, e os registros são vulneráveis a violações de dados. Por sua vez, a empresa poderia usar esses dados para treinar modelos futuros. Para os pais que não estão familiarizados com esses termos, isso significa que as mensagens privadas de seu filho podem ser visualizadas internamente ou até mesmo expostas em uma violação de dados.

- Política de dados opacos: A empresa não é transparente quanto ao tempo de retenção dos dados. Além disso, não está claro exatamente com quais terceiros ela compartilha as informações dos usuários (por exemplo, parceiros de análise). Isso gera preocupações com a privacidade a longo prazo.

- Potencial de manipulação: Qualquer informação pessoal que uma criança revele pode ser usada pela IA - ou pelo programador da IA - para criar uma conexão emocional mais profunda e manipuladora.

Medidas de segurança proativas e controles parentais do Character AI

Em resposta às preocupações do público e dos pais, a Character AI introduziu atualizações específicas de segurança:

- Recurso Parental Insights: O Character AI oferece um recurso limitado. O adolescente deve optar por compartilhar um relatório semanal de atividades com o e-mail dos pais. Esse relatório inclui o tempo médio diário gasto e os principais personagens com os quais o adolescente interagiu. É importante ressaltar que esse recurso NÃO fornece acesso ao conteúdo das conversas. Embora essas atualizações sejam um passo na direção certa, elas ainda não oferecem visibilidade real para os pais ou controle de conteúdo.

- Ajustes de modelo: A empresa fez alterações nos modelos de IA subjacentes usados por menores. O objetivo é reduzir as chances de encontrar conteúdo inadequado.

- Isenção de responsabilidade de conteúdo: A plataforma adicionou lembretes e notificações aos usuários. Eles afirmam que os chatbots não são pessoas reais.

- Notificações de tempo: As notificações de duração de sessão aparecem após uma hora de uso. Elas incentivam os usuários a fazer pausas.

- Moderação ativa: A empresa aumentou a intervenção quando os usuários violam os Termos de Serviço. Isso inclui a remoção de caracteres sinalizados e a exclusão de históricos de bate-papo relacionados.

Controles parentais de IA de personagens: Quais são as opções que os pais têm?

A IA de caracteres não permite que os pais visualizem os registros de bate-papo - o ponto de dados mais importante. Portanto, os pais precisam contar com soluções externas e estratégias proativas.

1. As 5 dicas essenciais de segurança para adolescentes em IA de personagens

Essas dicas estão alinhadas com as práticas recomendadas para garantir uma experiência segura quando a própria plataforma oferece proteção limitada:

- Exigir o uso em áreas comuns: Estabeleça regras que exijam que seu filho use a plataforma em espaços compartilhados, como a cozinha ou a sala de estar, em vez de usá-la em particular no quarto.

- Verifique regularmente seu uso: Mantenha a comunicação aberta. Analise periodicamente a atividade deles no aplicativo, usando o recurso limitado Parental Insights como um ponto de discussão.

- Discutir o uso adequado da IA: Fale sobre a diferença entre bate-papo amigável e assuntos inadequados. Lembre-os de que a IA pode mentir e que os bots rotulados como "Therapist" não têm treinamento profissional.

- Incentive as amizades na vida real: A IA não deve substituir a interação humana. Apoie seus hobbies em grupo. Além disso, incentive atividades sociais off-line para promover habilidades sociais saudáveis e evitar a dependência emocional.

- Lembre-os do motivo pelo qual protegemos informações confidenciais: Mesmo sendo uma IA, o compartilhamento de dados pessoais (localização, escola etc.) pode expô-los a riscos do mundo real ou levar à manipulação da IA.

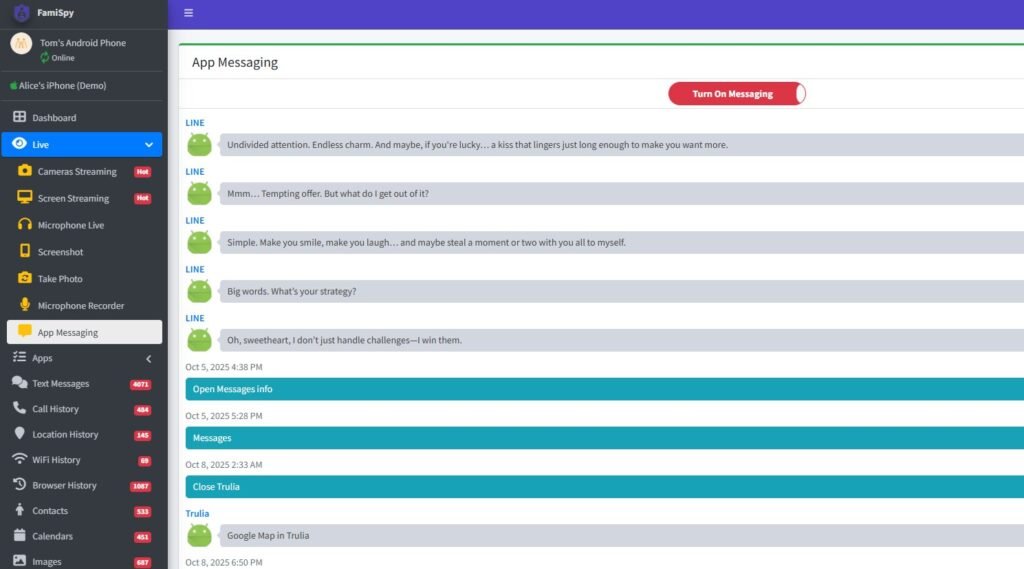

2. Utilização de aplicativos de controle dos pais (recomendado)

Para obter insights mais profundos e gerenciar os limites em todos os dispositivos, um aplicativo abrangente de controle dos pais é altamente recomendado. Uma plataforma líder de controle parental (como FamiSpy) pode proporcionar uma supervisão poderosa, permitindo que você:

- Monitorar o uso do aplicativo: Acompanhe o tempo que seu filho passa no Character AI, independentemente dos relatórios da própria plataforma.

- Exibir atividade mais ampla: Dependendo do dispositivo, alguns aplicativos podem monitorar a entrada de texto na tela. Como resultado, eles fornecem detecção de palavras-chave relacionadas a automutilação, conteúdo sexual ou bullying que a própria plataforma mantém oculta para você.

- Rastreamento de localização por GPS: Oferece proteção de segurança física em tempo real, garantindo que seu filho permaneça em zonas seguras predeterminadas.

O uso desse tipo de ferramenta externa ajuda a aplicar o controle quando o próprio aplicativo não oferece nenhum. Dito isso, isso aborda diretamente a necessidade de controles parentais de IA de caráter.

Melhores aplicativos de bate-papo com IA seguros para crianças (alternativas ao Character AI)

Se você estiver procurando uma interação de bate-papo com IA com recursos de segurança mais robustos, considere estas alternativas:

- Ferramentas educacionais de IA: Muitas plataformas estabelecidas, como Google e Microsoft, oferecem ferramentas de IA integradas em seus produtos. Elas geralmente vêm com filtros mais rígidos e voltados para a educação.

- PolyBuzz ou Talkie AI: Embora todos os aplicativos tenham riscos, pesquisar "O PolyBuzz é seguro para crianças" ou "O Talkie AI é seguro para crianças" indica que alternativas estão sendo consideradas. Sempre examine as políticas de privacidade e segurança de qualquer novo aplicativo de IA antes de permitir o uso.

Perguntas frequentes sobre a segurança da IA de personagens

Conclusão

A pergunta "A IA de caracteres é segura?" não tem uma resposta simples de sim ou não. Entretanto, os riscos potenciais são altos e legalmente demonstrados.

Devido à falta de acesso a registros cruciais de bate-papo, ao alto risco de apego emocional e ciclos de feedback perigosos, além da possível exposição a conteúdo nocivo criado pelo usuário e desinformação, não recomendamos o uso do Character AI para crianças com menos de 16 anos de idade.

Para adolescentes a partir de 16 anos, ele pode ser uma saída relativamente segura e criativa. No entanto, isso só é verdade com o envolvimento consistente dos pais, diálogo aberto, uma regra rígida sobre o uso do aplicativo em áreas comuns e o uso de ferramentas de monitoramento externo (como o FamiSpy) para garantir a responsabilidade e limites digitais saudáveis.

Em última análise, a melhor defesa não é apenas conhecer os riscos, mas também gerenciar ativamente o ambiente digital de seu filho.

Não perca: